long context를 어떻게 처리할지, AI에서는 굉장히 중요한 문제이다.

Transformer,, 굉장하지만 단점이 너무나도 명확하다. 바로 quadratic-compute 이다.

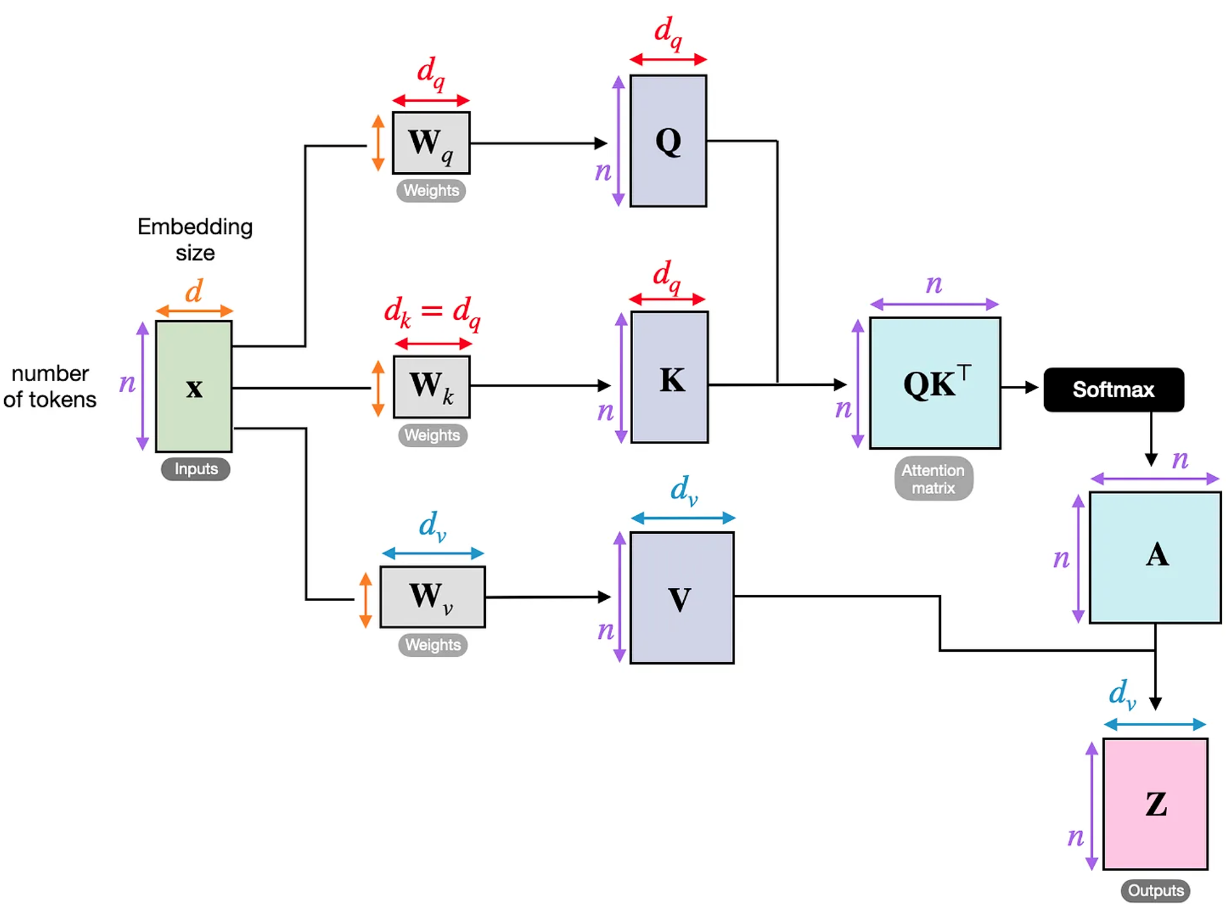

어디서 bottleneck이 발생하냐면, transformer의 selfattention 그림인데, attention matrix부분을 보자. attention matrix이 n^2 이 되는데, 그럼 number of token이 많아지면 n^2배만큼 quudratic하게 늘어나게 될것이다.