강화학습은 인간 선호도를 반영하는 데 매우 유용하지만, 단순히 “최종 점수만 주는 보상 모델”은 부정확한 신호를 줄 수 있다. 왜냐하면 추론 과정이 얕거나 불투명하기 쉽기 때문이다.

이 문제를 해결하기 위해, 논문에서는 긴 Chain-of-Thought(CoT) 기반 보상 모델을 제안한다. 주요 가정은 다음과 같다:

- CoT를 통해 다단계 추론을 하면, 보상 신호의 정확도와 신뢰도가 크게 높아진다.

- 모델이 충분히 CoT를 학습하면, “암묵적 추론”만으로도 상당한 성능을 낼 수 있다.

이 논문에서는 멀티모달 Reward Model에 긴 CoT 추론을 더해서, 복잡한 비전 task에서 신뢰도 높은 보상 신호를 제공하도록 만든다. 이를 위해,exploration-driven reinforcement fine-tuning이 제안되었다.

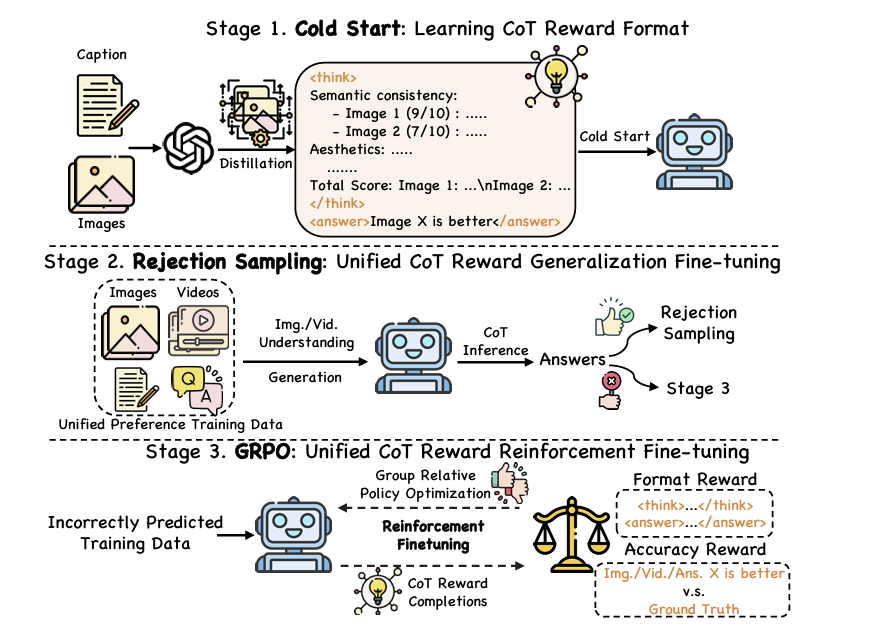

아래 그림을 보면, 전체 학습 프로세스는 크게 세 단계로 구성된다:

- Cold Start: 제한된 양의 “CoT 보상 데이터”로부터 모델이 단계적 추론 포맷을 학습하도록 초기화한다.

- Rejection Sampling: 대규모 멀티모달 preference 데이터를 투입하여, 모델이 CoT 추론을 수행하게 하고, 올바른 추론만 선별하여 재학습한다.

- Group Relative Policy Optimization : 이전 단계에서 놓친(잘못된) 예측들을 활용해, verifiable reward를 기준으로 강화학습을 진행한다

이 과정을 통해 모델은 단순히 최종 점수만 맞추는 것이 아니라, 내부적으로 COT를 학습해서 더 정확하게 강화학습을 할수 있다

Cold Start: Learning CoT Reward Format:

- VLM은 이미 복잡한 추론을 할 잠재력을 갖고 있으나, “보상 모델”로서 훈련된 적이 없어 구체적인 추론 포맷이 잡혀 있지 않다.

- 그 결과, 모델이 추론을 시도하더라도 형식이 산만하거나 얕은 내용을 뱉을 수 있다.

따라서~

- 소량의 CoT 데이터 준비:

- 예: 이미지 생성 선호도 데이터(“이미지A vs. 이미지B, 어느 쪽이 낫나?” 등)를 GPT-4o에 입력하여, 긴 CoT 추론 과정 및 최종 답변을 얻는다.

- 이 중, 최종 답변이 정확하게 나온 샘플만 distill 하여 (x, y) 형태의 학습 데이터로 사용한다.

- Objective Function:이 단계에서는 negative log-likelihood loss를 사용하여, 모델이 “여러 단계로 이어지는 추론 시퀀스”를 잘 학습하도록 만든다:

- \(T\): 전체 토큰(단어) 길이

- \(y_i\): 현재 토큰, \(y_{<i}\): 이전까지의 토큰, \(x\): 입력(이미지·프롬프트 등)

- \[ \mathcal{L}_{\mathrm{cold\_start}}(\theta) = - \sum_{i=1}^{T} \log \; p\bigl(y_i \mid x,\; y_{<i};\; \theta\bigr). \]

결과적으로, Cold Start 단계에서는 모델이 “긴 단계적 추론 포맷을 어떻게 표현해야 하는지”를 배운다. 이렇게 초기화된 모델은 이후에 Rejection Sampling과 GRPO를 거치게된다.

Rejection Sampling: Unified CoT Reward Generalization Fine-Tuning

Cold Start를 통해 모델이 CoT 형식을 인지했어도, 아직 충분한 일반화 능력을 얻지는 못했을 수 있다. 여기서 Rejection Sampling을 통해, “올바른 추론”만을 남겨 모델 학습을 계속한다.

- 대규모 멀티모달 데이터 활용:

- 생성 task : 텍스트 프롬프트(명령 + 캡션) + 이미지/영상 쌍

- undrestanding task: 텍스트 프롬프트(명령 + 질의) + 이미지/영상

- 올바른 결과만 선별:

- 정답과 일치하는 최종 답변을 낸 경우만 남기고, 잘못된 응답은 Rejection 처리하여 이후 학습에서 제외한다.

- 이렇게 걸러진 (x′, y′) 샘플들에 대해, Cold Start 때와 같은 방식으로 모델을 다시 학습한다.

- 효과:

- 학습 분포가 정확한 추론 패턴 주변으로 집중되며, 모델이 보다 견고한 일반화 능력을 획득한다.

- 아직 완벽히 해결되지 않은 복잡한 샘플들은 다음 단계인 GRPO를 통해 처리한다.

GRPO: Unified CoT Reward Reinforcement Fine-Tuning

Rejection Sampling에서 맞는 답을 한 번 걸러냈더라도, 여전히 복잡한 추론 패턴을 가진 어려운 케이스는 남아 있을 수 있다. 이를 GRPO 강화학습으로 마저 해결한다.

Verifiable Reward

GRPO를 적용하려면, 모델이 생성한 여러 후보 응답들을 정량적 보상으로 평가할 수 있어야 한다. 여기서는 두 가지 보상 요소를 사용한다:

- Format Reward (\(r_{\mathrm{fmt}}\)):

<think>,<answer>태그가 올바른 구조로 포함되어야만 1점을 준다.- 이를 통해 모델이 체계적인 CoT 추론과 명확한 최종 답변을 구분하도록 유도한다.

- Accuracy Reward (\(r_{\mathrm{acc}}\)):

- 최종 답변(즉,

<answer>태그 안의 내용)이 정답과 일치하면 1점, 아니면 0점으로 준다. - 모델이 실제로 “정확한” 결론에 도달하도록 장려한다.

- 최종 답변(즉,

최종 보상 \(r\)는 다음과 같이 합산 형태로 정의한다:

\[ r = r_{\mathrm{fmt}} + r_{\mathrm{acc}}. \]

즉, 모델은 올바른 형식과 정답 일치 두 가지를 모두 만족해야만 높은 보상을 얻을 수 있다.

Reinforcement Fine-Tuning

이제 GRPO의 policy 업데이트 과정을 간략히 살펴보자.

- 후보 응답 샘플링:

- 이전 정책 \(\pi_{\theta_{\text{old}}}\)로부터 입력 \(x\)에 대해 \(N\)개의 후보 응답 \(\{o^{(1)}, \dots, o^{(N)}\}\)을 생성한다.

- 보상 평가:

- 각 응답에 대해 Format Reward, Accuracy Reward를 계산해, \(r^{(i)}\)들을 얻는다.

- 동일 그룹 내 보상의 평균, 표준편차를 이용해 Advantage \(\hat{A}^{(i)}\)를 정규화한다.

- polciy update:

- 새 policy \(\pi_{\theta_{\text{new}}}\)와 \(\pi_{\theta_{\text{old}}}\)의 확률 비 \(\text{ratio}^{(i)}\)를 계산한다: \[ \text{ratio}^{(i)} = \frac{\pi_{\theta_{\text{new}}}(o^{(i)} \mid x)} {\pi_{\theta_{\text{old}}}(o^{(i)} \mid x)}. \]

- 이 값을 \([1-\delta,\, 1+\delta]\) 구간으로 클리핑하여 학습 폭주를 방지하고, 참조 모델 \(\pi_{\text{ref}}\)와의 KL 발산을 추가 페널티로 주어 과도한 편차를 억제한다.

- 최종 손실함수는 다음과 같이 쓸 수 있다:\[ L_{\mathrm{grpo}}(\theta) = \mathbb{E}\Bigl[ \min\bigl(\text{ratio}^{(i)}, \text{clip}(\text{ratio}^{(i)}, 1-\delta, 1+\delta)\bigr) \cdot \hat{A}^{(i)} \;-\; \beta \cdot D_{\mathrm{KL}}(\pi_{\theta_{\text{new}}} \| \pi_{\text{ref}}) \Bigr]. \]

이를 통해 모델은 다양한 추론 경로를 탐색하며, 높은 보상(즉, 정확하고 체계적인 CoT 추론)에 해당하는 응답을 선호하도록 학습된다.

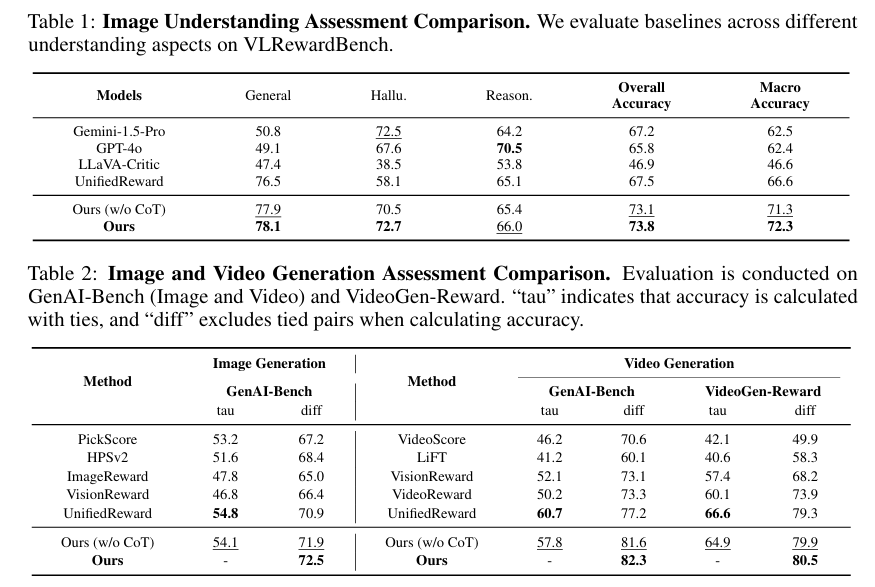

Experiments

이미지 생성, 비디오 생성, 이미지 이해, 비디오 이해 네 가지 영역에 대한 실험 결과이다

- 이미지·비디오 생성에선 모든 지표에서 안정적인 우위를 보였다.

- 이미지 이해 과제에서 특히 개선 폭이 컸는데, 이는 CoT 추론이 깊은 시각적 이해를 가능하게 했기 때문으로 보인다.

- 명시적으로 CoT를 출력하지 않고 “암묵적 추론”만 사용해도, 여전히 기존 모델보다 높은 성능을 보였다 (다소의 성능 하락은 존재).

Ablation Studies

두가지에 대한 ablation 결과가있었다

각 학습 단계의 효과:

- Cold Start: CoT 포맷을 학습하나, 정확도 자체는 아직 낮음.

- Rejection Sampling: 올바른 샘플만 남겨 지도 학습하므로 성능이 뚜렷이 향상됨.

- GRPO: 이전에 틀렸던 사례를 집중적으로 탐색·학습해 최대 성능 개선을 달성

CoT 없는 GRPO:

- 최종 답만으로 강화학습하면 약간 향상은 있으나, CoT를 명시적으로 학습했을 때만큼은 아니다.