Abstract & Intro

멀티모달 대형 언어 모델(MLLM)은 텍스트와 이미지를 동시에 이해하고 처리하는 능력을 보여준다. 그러나 현재의 MLLM은 종종 이미지와 관련 없는 잘못된 정보를 생성하는 문제를 가지고 있다. 이런 문제는 특히 신뢰성이 중요한 상황에서 MLLM을 실용적으로 사용하기 어렵게 만든다.

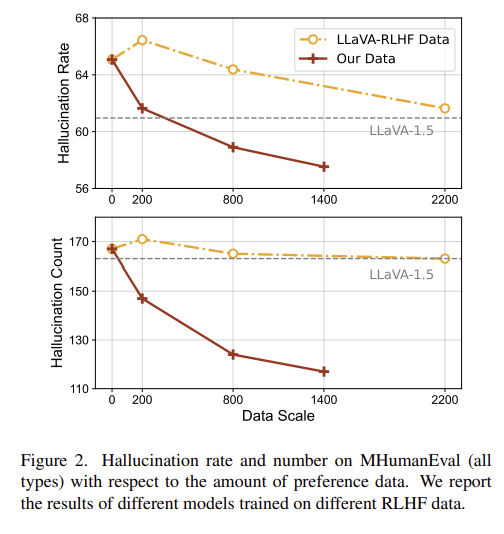

이를 해결하기 위해 RLHF-V라는 새로운 접근법이 소개된다. RLHF-V는 인간의 세밀한 피드백을 활용하여 모델의 행동을 조정함으로써 MLLM의 신뢰성을 향상시킨다. 구체적으로, RLHF-V는 인간이 모델이 잘못 이해한 부분을 수정한 내용을 수집한다. 그런 다음, 이 피드백을 기반으로 모델을 최적화하여, 모델이 텍스트와 이미지를 더 정확하게 일치시킬 수 있도록 한다.

전통적인 인간 피드백을 활용한 강화학습 RLHF는 두가지 주요 문제가 있는데, 첫번쨰는 주석의 모호성이다.

여기서 A랑 B response에서 보이는것 처럼, 이미지에 대한 MLLM output은 주로 길고 복잡해서, 인간이 feedback하거나 판단하기 어려울 수 있다.

두번째는 학습 효율성인데, 많은 양의 label 데이터가 필요하다는 문제점이 있고, 데이터의 bias등으로 모델이 편향될 수 있다는 문제가 있다

이 논문에서는 두가지 contribution을 통해 이 문제를 해결하는데

- 1. 데이터 수준에서 : 인간 피드백을 fine-grained correctional human feedback, 즉 모델 응답에서 hallucinated 된 부분을 직접 수정하도록 요청해서 명확한 feedback이 가능하게 하고

- 2. 방법론적인 contribution : DDPO, 전통적인 RLHF objective를 지도학습 방식으로 해결한다

Human preference Collection

입력 x(이미지와 프롬프트 포함)에 대해, 선호되는 출력 yw와 선호되지 않는 출력yl 사이의 차이를 Y로 나타낼 수 있다. 이 차이 Y는 다음 세 가지 요소로 나뉜다

$$ Y = Yp + Ys + Yn $$

여기서 Yp는 신뢰할 수 있고 도움이 되는 실제로 선호되는 행동을 나타내고, Ys는 데이터와 관련 있지만 인간의 판단과는 무관한 shallow non robust bias(예: yw가 특정 단어를 더 많이 사용하는 경우)를 나타낸다. Yn은 랜덤 노이즈(같은 의미의 단어를 표현하는 다른 방식) 이다. Yp 요소는 학습해야 하는것, Ys 요소는 피해야하는것(학습하면 reward hacking 문제가 발생할 수 있으므로). Yn 요소는 선호 학습에 편향을 주지는 않지만 학습을 더 어렵게 만들어 더 많은 레이블 데이터가 필요하므로 가능한 한 피하는 것이 좋음.

아까 intro에서 언급했던 주석의 모호성과, 학습 효율성 문제를 해결하기 위해, segment-level correction형태로 fine-grained한 인간 선호를 수집하는 방법이 제안되었다.

human labler이 MLLM의 잘못된 출력 yl에서 hallucinated된 세그먼트를 직접 수정하여 사실적으로 최적의 출력 yw를 만들도록 요청한다.. 이 lableing과정에서 세그먼트 수준의 쌍(yw, yl)이생성된다. 이렇게 하면 다음과 같은 장점이 있음.

- 세그먼트에서 점진적 수정에 대한 주석은 더 명확하고 인간 주석자에게 더 조작 가능하게 만든다

- 이런 fine grained된 피드백은 직접 선호 행동 Yp에 할당되어 Yn과 Ys를 배제하므로 학습 효율성을 높이고 reward hacking 문제를 방지한다

Method

RLHF-V 접근법은 fine grained corrected 인간 피드백을 Dense Direct Prefeence Optimization을 통해 학습합니다. 또한, vision-language 불일치 문제를 해결함으로써 MLLM 훈련에서 발생하는hallucination 문제를 해결한다.

3.1 Dense Direct Preference Optimization

인간 선호에 대해 MLLM 정책을 직접 최적화하는 새로운 형태의 DDPO를 제시한다. 기존의 RLHF 접근법은 보상 모델을 선호 데이터에 맞춘 후, reference 모델에서 크게 벗어나지 않도록 보상을 최대화하는 방식으로 traiing 을 시킨다. 근데 이는 다수의 LLM을 광범위한 샘플링과 훈련으로 인해 복잡한 절차와 높은 계산 비용을 필요로 한다.

DPO는 이러한 강화 학습 목표를 더 간단한 supervised 방식으로 해결한다. DPO의 주요 아이디어는 보상 함수 \( r(x, y) \)가 \( \pi_*(y|x) \)와 reference 모델\( \pi_{\text{ref}}(y|x) \)로 표현될 수 있다는 것. 따라서 우리는 적절한 형태로 선호 데이터에서 직접 정책 모델을 최적화할 수 있다. 구체적으로, 보상 모델 \( r(x, y) \)는 다음과 같이 표현될 수 있다:

$$ r(x, y) = \beta \log \left( \frac{\pi_*(y|x)}{\pi_{\text{ref}}(y|x)} \right) + \beta \log Z(x) $$

여기서 \( \beta \)는 상수이고, \( Z(x) \)는 정규화 함수. 이 수식을 통해 정책 모델을 인간 피드백 데이터에서 직접 최적화할 수 있다.

이걸 바탕으로 정책 모델은 인간 피드백 데이터에서 직접 최적화될 수 있다:

$$ \mathcal{L} = -\mathbb{E}_{(x, y_w, y_l)} [ \log \sigma(r(x, y_w) - r(x, y_l)) ] $$

이는 다음과 같이 세분화될 수 있다:

$$ \mathcal{L} = -\mathbb{E}_{(x, y_w, y_l)} \left[ \log \sigma \left( \beta \log \left( \frac{\pi_*(y_w|x)}{\pi_{\text{ref}}(y_w|x)} \right) - \beta \log \left( \frac{\pi_*(y_l|x)}{\pi_{\text{ref}}(y_l|x)} \right) \right) \right] $$

여기서 \(\sigma\)는 시그모이드 함수이며, 각 샘플 \( (x, y_w, y_l) \)은 입력 이미지와 프롬프트 \( x \), 선호되는 출력 \( y_w \), 열등한 출력 \( y_l \)로 구성됩된다

레퍼런스 모델 \( \pi_{\text{ref}}(y|x) \)은 우리가 개선하고자 하는 instruction 튜닝된 기본 모델로 구현되며, DPO 훈련 동안은 freezed 상채. \( \pi_*(y|x) \)만 업데이트된다

이걸 segment level에서 다시 생각해보면

응답 \( y \)의 i번째 토큰이 \( y_i \)라고 할 때, 응답 \( y \)에 대한 로그 확률은 다음과 같이 표현된다:

$$ \log \pi(y|x) = \sum_{y_i \in y} \log p(y_i|x, y_{<i}) $$

여기서 \( y_i \)는 응답 \( y \)의 i번째 토큰. 수정되지 않은 세그먼트 \( y_u \)와 비교했을 때, 수정된 세그먼트 \( y_c \)가 hallucination에 대한 인간 판단을 더 직접적으로 나타내므로 전체 응답 평가에 더 크게 기여해야 한다고 논문에서 주장되어있음. 따라서, 응답을 아래 수식을 이용해 세그먼트의 가중치 합으로서 점수를 매기도록함

$$ \log \pi(y|x) = \frac{1}{N} \left[ \sum_{y_i \in y_u} \log p(y_i|x, y_{<i}) + \gamma \sum_{y_i \in y_c} \log p(y_i|x, y_{<i}) \right] $$

여기서 \( \gamma > 1 \)은 가중치 하이퍼파라미터로, 더 큰 \( \gamma \)는 수정된 세그먼트의 기여도가 더 커짐을 의미함. \( N = |y_u| + \gamma |y_c| \)는 normalizing factor로, 더 긴 응답이 더 높은 점수를 얻는 것을 방지함. 이 방식으로 수정된 세그먼트는 더 강한 인간 선호 피드백을 받아 사실적으로 근거 있는 응답을 생성하도록 강조된다.

3.1 Mitigating Hallucination from VL mismatch

일반적으로 현재의 MLLM은 supervised learning 방식으로 멀티모달을 학습한다. 이 방식에서는 모델의 출력이 이미지와 관련된 실제 텍스트와 비교되어 학습이 된다 이러한 방식에서는 이미지와 텍스트 데이터 간의 불일치로 인해 hallucination이 발생할 수 있다. 실제로 이러한 불일치는 다음과 같은 원인에서 발생할 수 있다: (1) pretrained 및 데이터의 low qualitiy 텍스트, (2) 훈련 중 부주의한 image augmentation

이를 해결하기 위해

(1) low quality text 문제

현재 MLLM의 사전 학습 데이터는 웹에서 자동으로 수집되며, 이 과정에서 많은 텍스트 노이즈가 발생해 모델을 hallucinate하게 한다. 예를 들어, 존재하지 않는 요소를 설명하거나 이미지와 일치하지 않는 설명을 생성하게 됨. 기존의 데이터셋도 gpt로 생성되어 hallucination이 생김. 문제를 해결하기 위해, MLLM을 고품질의 시각적 질문-응답 데이터셋으로 사후 학습시키면 모델의 행동을 교정하고 지시를 따르는 능력을 향상시킬 수 있음. 논문의 실험에서는 VQAv2 데이터셋으로 파인튜닝하는것만으로도 hallucination을 줄일 수있음을 발견함

(2) 과도한 image augmentation

이미지 augmentation은 보통 데이터 다양성을 늘리기 위해 사용되는데, MLLM에서는 이를 신중하게 고려해봐야함. 왜냐하면, 이미지 augmentation이 이미지의 의미를 크게 변경할 수 있음. 예를 들어 랜덤 크로핑을 하게 되면 text 에서 언급된 객체가 아예 이미지에서 사라져버릴 수도 있음. 그래서 이 논문에서는 이미지 크로핑을 제외시켰음.